隨著大數(shù)據(jù)技術(shù)的快速發(fā)展,Spark作為一種高效、可擴展的分布式計算框架,已在數(shù)據(jù)處理領(lǐng)域占據(jù)重要地位。它不僅能夠處理大規(guī)模數(shù)據(jù)集,還提供了豐富的API和庫,支持多種數(shù)據(jù)處理任務(wù)。本文將重點介紹Spark的核心特性、數(shù)據(jù)處理流程及其在實際應(yīng)用中的優(yōu)勢。

一、Spark的核心特性

- 高速計算能力:Spark通過內(nèi)存計算技術(shù)大幅提升了數(shù)據(jù)處理速度,相比傳統(tǒng)的MapReduce框架,其性能可提升數(shù)倍至數(shù)十倍。這得益于Spark的彈性分布式數(shù)據(jù)集(RDD)模型,允許數(shù)據(jù)在內(nèi)存中進行多次迭代計算,減少了磁盤I/O開銷。

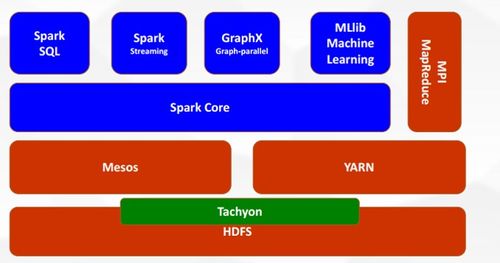

- 易用性:Spark提供了多種編程語言的API,如Scala、Java、Python和R,使得開發(fā)人員能夠快速上手。Spark還集成了高級庫,如Spark SQL用于結(jié)構(gòu)化數(shù)據(jù)處理,Spark Streaming用于實時流處理,MLlib用于機器學習,GraphX用于圖計算,滿足了多樣化的數(shù)據(jù)處理需求。

- 容錯性:Spark通過RDD的 lineage(血統(tǒng))機制實現(xiàn)容錯。當某個節(jié)點失敗時,Spark可以根據(jù)血統(tǒng)信息重新計算丟失的數(shù)據(jù)分區(qū),而無需將數(shù)據(jù)復(fù)制到多個節(jié)點,從而提高了系統(tǒng)的可靠性。

- 可擴展性:Spark可以運行在多種集群管理器上,如Apache Mesos、Hadoop YARN或Spark自帶的獨立集群模式。它能夠輕松擴展到數(shù)千個節(jié)點,處理PB級別的數(shù)據(jù),適用于企業(yè)級的大規(guī)模應(yīng)用。

二、Spark的數(shù)據(jù)處理流程

Spark的數(shù)據(jù)處理通常遵循以下步驟:

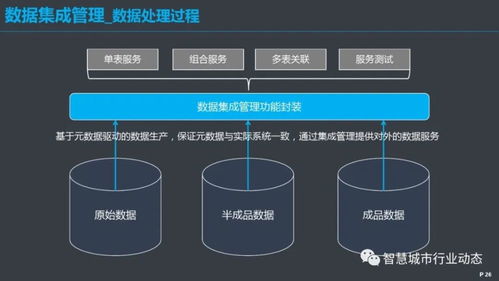

- 數(shù)據(jù)輸入:Spark可以從多種數(shù)據(jù)源讀取數(shù)據(jù),如HDFS、本地文件系統(tǒng)、Apache Kafka、Amazon S3或關(guān)系型數(shù)據(jù)庫。通過SparkContext或SparkSession,用戶可以加載數(shù)據(jù)并創(chuàng)建RDD、DataFrame或Dataset對象。

- 數(shù)據(jù)轉(zhuǎn)換:Spark提供了豐富的轉(zhuǎn)換操作(如map、filter、reduceByKey),允許用戶對數(shù)據(jù)進行清洗、聚合或轉(zhuǎn)換。這些操作是惰性執(zhí)行的,只有在觸發(fā)行動操作(如count、save)時才會實際執(zhí)行,這有助于優(yōu)化執(zhí)行計劃。

- 數(shù)據(jù)緩存:對于需要多次使用的中間數(shù)據(jù),用戶可以將其緩存到內(nèi)存中,以加速后續(xù)計算。Spark的緩存機制智能地管理內(nèi)存,根據(jù)需求自動調(diào)整存儲策略。

- 數(shù)據(jù)輸出:處理后的結(jié)果可以保存到文件系統(tǒng)、數(shù)據(jù)庫或?qū)崟r流中。Spark支持多種輸出格式,包括文本、Parquet、JSON等,方便與其他系統(tǒng)集成。

三、Spark在實際應(yīng)用中的優(yōu)勢

Spark已被廣泛應(yīng)用于各行各業(yè):

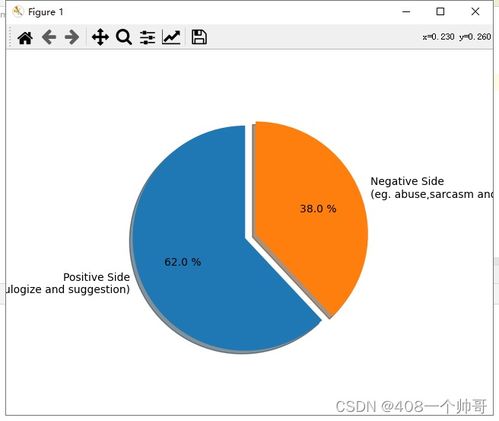

- 金融行業(yè):銀行和保險公司使用Spark進行實時欺詐檢測和風險分析,通過處理海量交易數(shù)據(jù),快速識別異常模式。

- 電商領(lǐng)域:企業(yè)利用Spark分析用戶行為數(shù)據(jù),實現(xiàn)個性化推薦和庫存優(yōu)化,提升用戶體驗和運營效率。

- 醫(yī)療健康:研究機構(gòu)采用Spark處理基因組數(shù)據(jù)或醫(yī)療記錄,加速疾病預(yù)測和藥物研發(fā)過程。

- 物聯(lián)網(wǎng)(IoT):在智能家居或工業(yè)物聯(lián)網(wǎng)中,Spark Streaming能夠?qū)崟r處理傳感器數(shù)據(jù),實現(xiàn)設(shè)備監(jiān)控和預(yù)警。

四、總結(jié)

Spark作為大數(shù)據(jù)處理的核心框架,以其高速、靈活和易用的特點,幫助企業(yè)高效地挖掘數(shù)據(jù)價值。隨著人工智能和實時分析的普及,Spark的未來發(fā)展將更加注重與云平臺、深度學習框架(如TensorFlow)的集成。對于數(shù)據(jù)工程師和科學家來說,掌握Spark是應(yīng)對大數(shù)據(jù)挑戰(zhàn)的關(guān)鍵技能。通過合理利用Spark的分布式計算能力,用戶可以構(gòu)建可擴展的數(shù)據(jù)管道,推動業(yè)務(wù)創(chuàng)新和決策優(yōu)化。