隨著大數據時代的到來,數據已成為企業和社會發展的核心資產。海量數據的涌現也帶來了治理難題。從技術視角來看,大數據治理的核心在于數據處理,它涉及數據的采集、存儲、清洗、整合與分析等多個環節。有效的治理能夠確保數據的質量、安全與合規性,從而最大化數據的價值。

數據采集是大數據治理的起點。現代技術如物聯網傳感器、日志收集工具和API接口等,使得企業能夠實時獲取多樣化的數據源。采集過程中需注意數據的完整性和準確性,避免引入噪聲或偏差。例如,在金融行業,通過實時監控交易數據,可以快速檢測欺詐行為,但若數據源不可靠,可能導致誤判。因此,采用標準化協議和驗證機制是技術實現的關鍵。

數據存儲與清洗是確保數據可用性的基礎。大數據通常存儲在分布式系統如Hadoop或云平臺中,這些技術提供了高可擴展性和容錯能力。但原始數據往往包含冗余、不一致或缺失值,需通過ETL(提取、轉換、加載)流程進行清洗。技術工具如Apache Spark或Talend能夠自動化處理數據轉換,提升數據質量。例如,在電商平臺,清洗用戶行為數據后,可以更精準地推薦產品,從而提高用戶體驗。

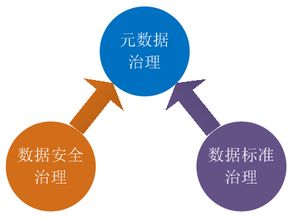

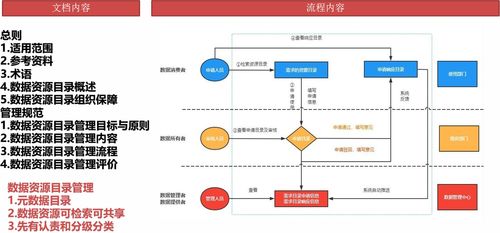

接著,數據整合與治理框架的構建是技術視角下的核心挑戰。大數據常來自異構源,如結構化數據庫和非結構化社交媒體數據,整合時需要統一數據模型和元數據管理。技術解決方案包括數據湖架構和主數據管理(MDM)系統,它們幫助實現數據的一致性和可追溯性。治理工具如Collibra或Apache Atlas提供數據血緣追蹤和策略執行,確保數據生命周期中的合規性。以醫療行業為例,整合患者記錄和科研數據時,必須遵守隱私法規如HIPAA,這要求技術在加密和訪問控制上做到精細管理。

數據分析與應用是數據治理的最終目標。通過機器學習算法和可視化工具,企業可以從數據中挖掘洞察,驅動決策。但技術實現需平衡性能與成本,例如使用實時流處理技術如Apache Kafka應對高并發場景。數據治理還需關注倫理問題,如算法偏見,這要求技術設計融入公平性檢查。

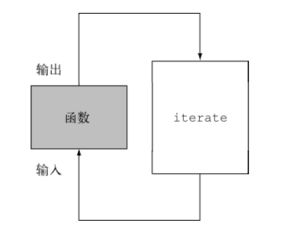

從技術視角看,大數據治理的數據處理環節是一個系統工程,涉及采集、存儲、清洗、整合和分析等多個層面。通過采用先進工具和框架,企業可以構建高效、安全的治理體系,釋放數據潛力。隨著人工智能和邊緣計算的發展,大數據治理技術將更智能化,助力各行各業實現數字化轉型。